Wie mit der Hilfe von Microsoft Defender for Endpoint und Microsoft Defender for Cloud Apps die Nutzung von Generativer KI gesteuert werden kann.

Puh, ich weiß nicht, wie es euch geht, aber das erste Quartal 2024 ist ziemlich schnell verflogen und damit verbunden war bei mir irrsinnig viel zu tun. Jetzt im Mai habe ich endlich wieder etwas Luft, um diesen Artikel zu schreiben, den ich schon länger auf der To-Do Liste stehen habe.

Denn, in meinen Diskussionen mit Kunden und Microsoft Partnern, kommt regelmäßig – ja eigentlich immer – die Frage auf: Wie können wir verhindern, dass unsere Nutzerinnen1 KI-Tools verwenden, ohne dass wir diese freigegeben, geprüft und legitimiert hätten oder überhaupt davon wüssten, dass dies geschieht? Neudeutsch heißt das jetzt „BYOAI“ – also „Bring your own AI“.

Und schlimmer noch: wir müssen das sogar gegebenenfalls, weil es sich aus der EU KI Verordnung/AIAct für Arbeitgeber vermutlich ergibt (bitte euren Rechtsbeistand dazu fragen, ich kann keine Rechtsberatung durchführen!), zumindest organisatorisch – besser jedoch auch technisch – steuern und regeln.

Update: Neben der in diesem Post beschriebenen Vorgehen gibt es auch einen flexibleren Weg, bei dem wie mit einem Skalpell die einzelnen Dienste und Daten individuell behandelt werden können. Dies habe ich in

One Size fits all! Oder auch nicht! – Ausgeklügelter Umgang mit Firmendaten und GenAI Diensten

einfach herausgearbeitet, schaut also auch unbedingt dort hinein!

Aigis beteutet so viel wie Schild oder Schutz. Vgl. Aigis – Wikipedia

Agenda

- Was ist eigentlich das Problem mit der Nutzung von beliebigen, nicht gemanagten KI Tools

- Klassische, wenig funktionierende Lösungsversuche

- Moderne und funktionierende Lösung

- Fazit

Was ist eigentlich das Problem mit der Nutzung von beliebigen, nicht gemanagten KI Tools?

Ich bin davon überzeugt, dass KI Tools die Arbeitsweisen maßgeblich verändern werden und das für die meisten Menschen beziehungsweise Personas und Rollen.

Welche Tools wie am sinnvollsten eingesetzt werden können, das hängt stark von dem jeweiligen Vorgehen und „Workflow“ ab, kann also gar nicht granular verallgemeinert werden.

Dadurch bedingt, dass KI aktuell ein entsprechendes Hype Thema (oder sind wir gar schon weiter?) ist und damit auch bei allen Menschen – nicht nur den IT affinen – angekommen ist, wird viel ausprobiert. Vor allem dann, wenn die IT – also „die, die sich damit auskennen“ (sollten) – keine Vorgaben oder vorgefertigte Wege definiert.

Das wiederum führt dazu, dass die Menschen einfach irgendwelche Tools nutzen, die sie bei ihrer Recherche im Internet gefunden haben. Und das, ohne vor der Nutzung eine Bewertung hinsichtlich Datenschutzes oder Datensicherheit durchgeführt zu haben. Im neuen IT Sprech nennt man das „BYOAI“ (Bring your own AI).

Das soll übrigens kein Vorwurf für diese Menschen, die sich ihren Weg suchen, sein, denn diese sind oftmals nicht dafür ausgebildet die Bewertung auch fachmännisch zu tun – sondern eher ein Vorwurf an die ITs dieser Welt, dass diese hier ihrem Auftrag nicht nachkommen und den Usern entsprechende Wege aufzeigen. Siehe dazu meinen Artikel Jetzt ist der richtige Zeitpunkt, dass IT wieder „geil“ werden kann.

Das bedeutet, dass es durch dieses „einfach mal machen“ unter Umständen zu Datenverlust und einem entsprechenden Datenschutzrisiko kommt. Siehe Samsung workers made a major error by using ChatGPT | TechRadar

Und eins vorneweg: „du darfst keine KI Tools nutzen“ als reine, organisatorische Maßnahme funktioniert schlicht nicht!

Das Handelsblatt hat sich am heutigen 10.5.2024 auch mit der Thematik befasst: Schatten-KI: Sieben von zehn Arbeitnehmern nutzen KI-Werkzeuge ohne Freigabe ihrer Firma (handelsblatt.com) und dabei auch den Microsoft Work Trend Index herangezogen, bei dem es heißt, dass „75% der Knowledge Worker“ AI nutzen – nicht immer freigegeben durch die IT! 😱

Klassische, wenig funktionierende Lösungsversuche

Was macht man also als Unternehmen?

Richtig: wir verbieten die Nutzung von AI per Anweisung, also als organisatorische Maßnahme.

Das wird sicher funktionieren – hat es früher ja auch schon immer! 🙄🤣

Ok, wer dem nicht traut, der stellt noch an der Firewall ein, dass ChatGPT geblockt wird. Und Midjorney. Und Gemini. Und …

„Hm, habe ich auch keinen vergessen?“

Netzwerkadministrator bei der Firewallkonfiguration

Das hat gleich mehrere Fallstricke:

- Die Pflege der Firewallrules wünsche ich meinem ärgsten Feind nicht! Denn KI Tools sprießen grade wie Gänseblümchen im Frühjahr aus allen möglichen Böden! 🌼

- Alle Kommunikation müsste auch über die Firewalls laufen – %spoiler%: tut sie nicht! Vor allem, wenn wir Home Office und BYOD mit einbeziehen.

- Die Natur (aka Userinnen) finden ihren Weg!

Moderne und funktionierende Lösung

Wir stellen also fest: der alte Weg funktioniert hier nicht (wenn er denn jemals bei anderen Themen funktioniert hat).

Microsoft bietet für die Verwaltung von Generative AI / generativer KI Tools eine Lösung an, die automatisiert und vor allem unabhängig der Netzwerkinfrastruktur funktioniert.

Das dafür notwendige Tool heißt „Microsoft Defender for Cloud Apps (MDCA)“ (langjährige Leser wissen, dass das eins meiner absoluten Lieblingstools ist! 😍).

Die Konfiguration zur Steuerung von GenAI Tools ist sehr einfach – unter der Prämisse, dass zum einen alle genutzten Devices gemanaged und mit Microsoft Defender for Endpoint (MDE) ausgestattet sind.

Defender for Endpoint ist als lokale Komponente notwendig, damit wir ohne die Firewall trotzdem eine Steuerung der verwendeten Applikationen durchführen können. Sprich MDE ist unser Durchsetzungspunkt für die Policies, welche GenAI Tools erlaubt oder verboten sind.

Update 2025-03-26:

Mit der Ankündigungen der Security Copilot agents kommt auch die Ankündigung, dass über Microsoft Entra Internet Access eine neue Kategorie für die Web Content Filter kommen, über die das zukünftig ähnlich steuerbar sein wir:

Microsoft unveils Microsoft Security Copilot agents and new protections for AI | Microsoft Security Blog

Konfiguration MDCA

Um MDCA für diesen Zweck zu nutzen, müssen mehrere Dinge getan werden.

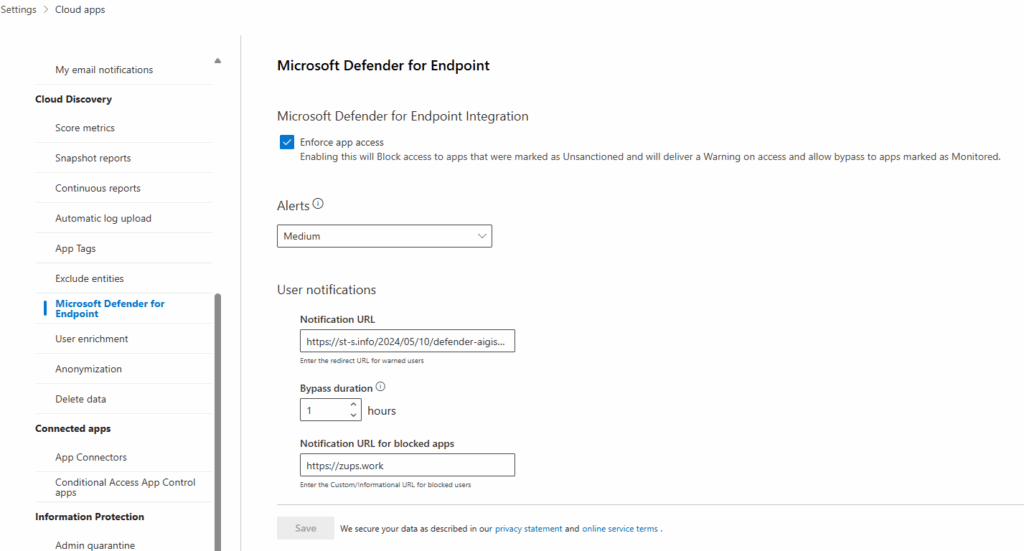

Zuallererst muss die Connection zwischen MDCA und MDE sichergestellt sein! (ich gehe hier davon aus, dass MDE bereits ausgerollt ist, um die Länge dieses Blogposts kurz zu halten):

Cloud Apps – Microsoft Defender

Wenn also die Verbindung sicher gestellt ist, dann sollte ich zwei weitere Dinge tun:

Bewertung von bekannten und genutzten KI Tools

Über das Cloud Discovery Feature von MDCA (siehe [GDPR Demopalooza] Welche Cloud Apps werden bei mir im Unternehmen verwendet und wie kann ich diese kontrollieren und steuern? (Defender for Cloud Apps, ShadowIT) ) muss erst einmal eine Betrachtung der aktuellen Nutzung erfolgen und gegebenen Falls auch damit vorab verbundene Freigabe oder Blockierung (siehe nächsten Abschnitt).

Und Teil dieser Betrachtung muss auch eine dokumentierte Bewertung und Entscheidung für eben die Freigabe oder Blockierung der Tools erfolgen.

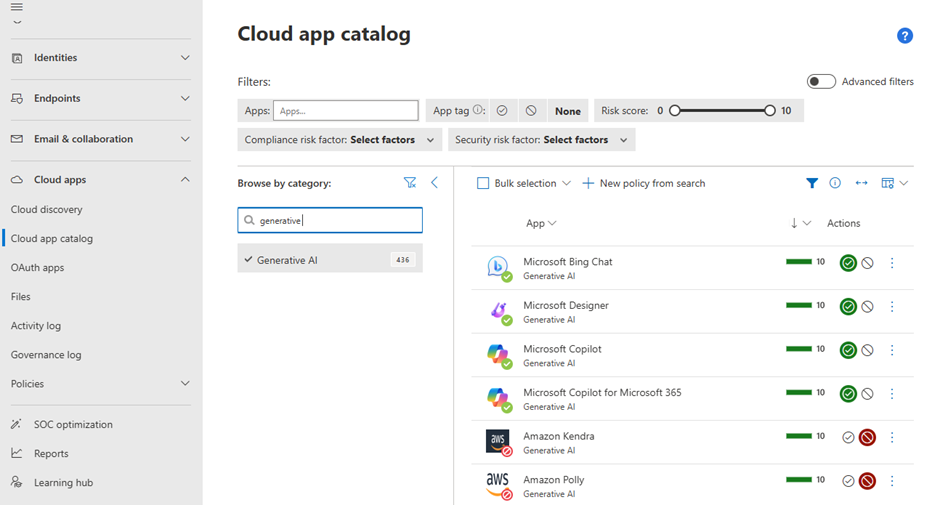

Die notwendigen Informationen und die Möglichkeit der technischen Durchsetzung der Entscheidung geschieht über das Cloud Discovery Dashboard beziehungsweise den Cloud App Catalog in MDCA:

Cloud app catalog – Microsoft Defender

Im Screenshot ist zu sehen, dass ich auf die App Kategorie „Generative AI“ gefiltert habe und, dass ich die ersten vier Apps auf den Status „erlaubt“ („sanctioned“) und die nachfolgenden auf „blockiert“ („unsanctioned“) gestellt habe.

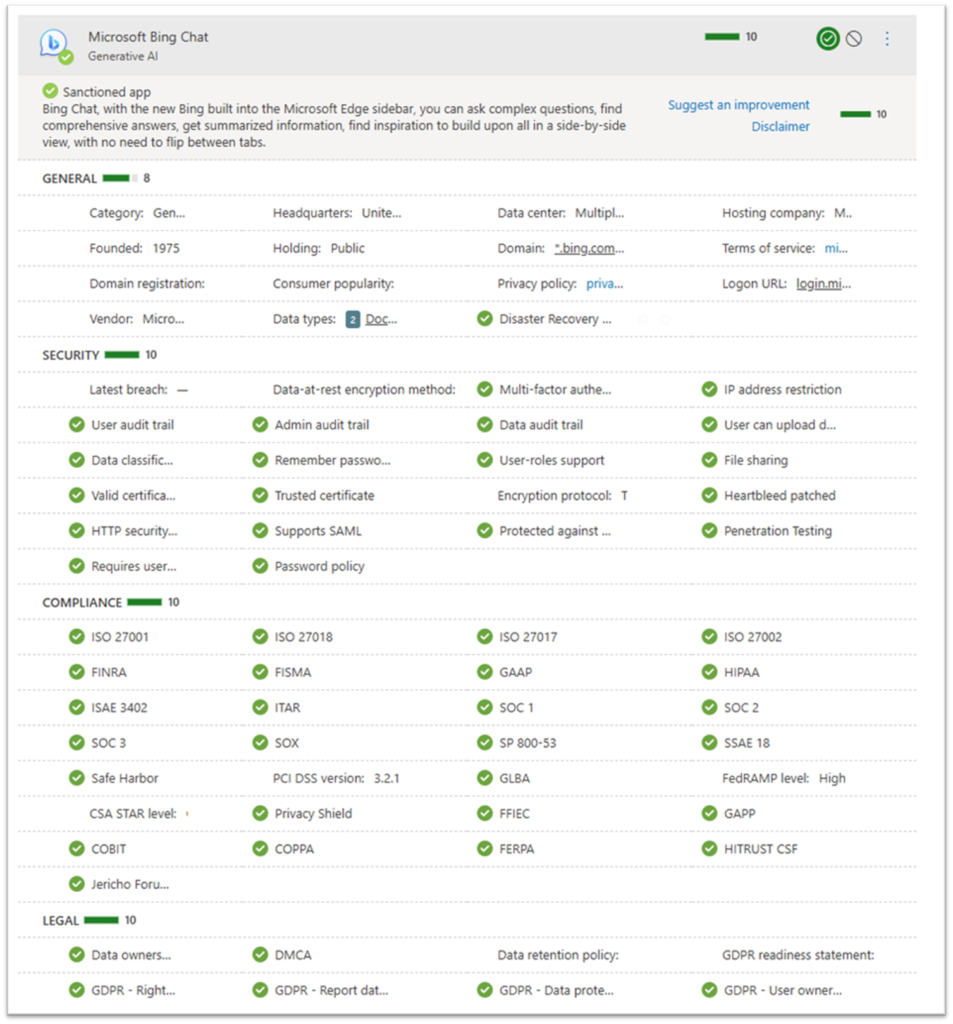

Für die Bewertung einer App bietet MDCA zusätzlich noch eine grobe Einordnung einer jeden App an, hier am Beispiel von Microsoft Bing Chat:

Diese Einordnung dient der ersten, schnellen Bewertung und entbindet nicht von der Verantwortung sich näher mit einer App zu beschäftigen!

Wenn ich dies für jede der aktuell 418 Generative AI Tools in MDCA tun wollte, dann würde ich vermutlich nicht viel anderes machen und könnte am Ende wieder vorne weitermachen, denn bei den 418 wird es sicher nicht bleiben.

Daher muss als nächster Schritt eine Automation eingeführt werden:

Automatisierung der Umsetzung

Ganz automatisieren lässt sich der Vorgang nicht, denn es bedarf immer eines Menschen die finale und dauerhafte Entscheidung zu treffen. Ich werde hier zeigen, wie eine App erstmal geblockt werden kann, die IT gleichzeitig notifiziert wird, dass eine App gerne genutzt werden würde und diese sich dann der entsprechenden App annehmen kann:

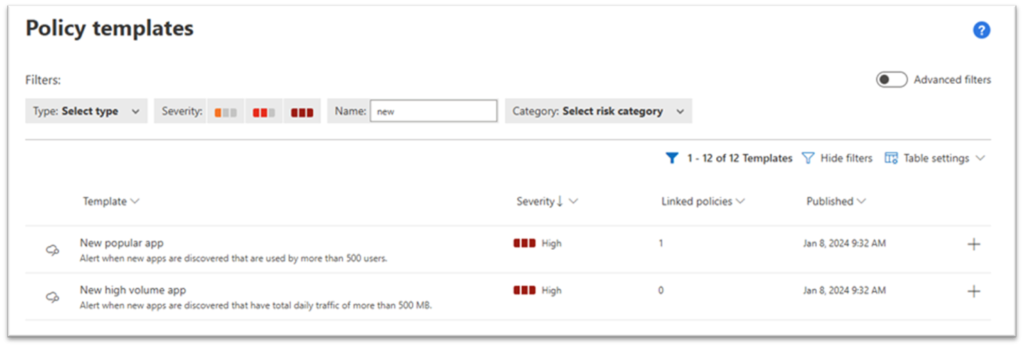

Um eine Automation zu erreichen, muss dazu eine sogenannte „Policy“ erstellt und genutzt werden.

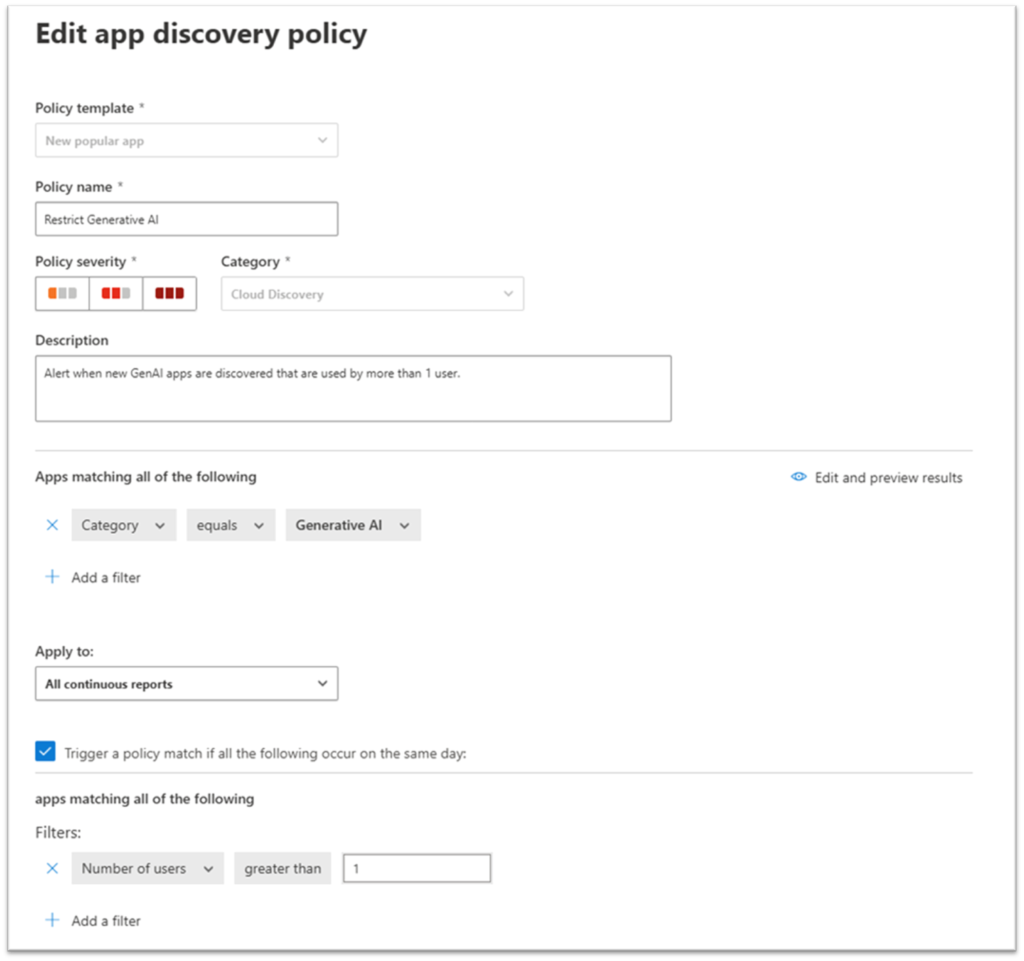

Dazu ist der schnellste Weg ein vorgefertigtes Template zu nutzen und anzupassen. Ich schlage dafür das Template „new popular App“ vor:

In diesem Template sind grundlegende Settings bereits vorkonfiguriert, ins besondere die Kategorie und das Setting für die Anzahl der User, die diese App nutzen.

Leider ist im Feld für die Anzahl der User der Wert 0 nicht erlaubt! 0️⃣

Mit diesen Settings stelle ich sicher, dass sobald eine App von mehr als einem User genutzt wird, und diese App aus der Kategorie „Generative AI“ ist, dann die Policy greift.

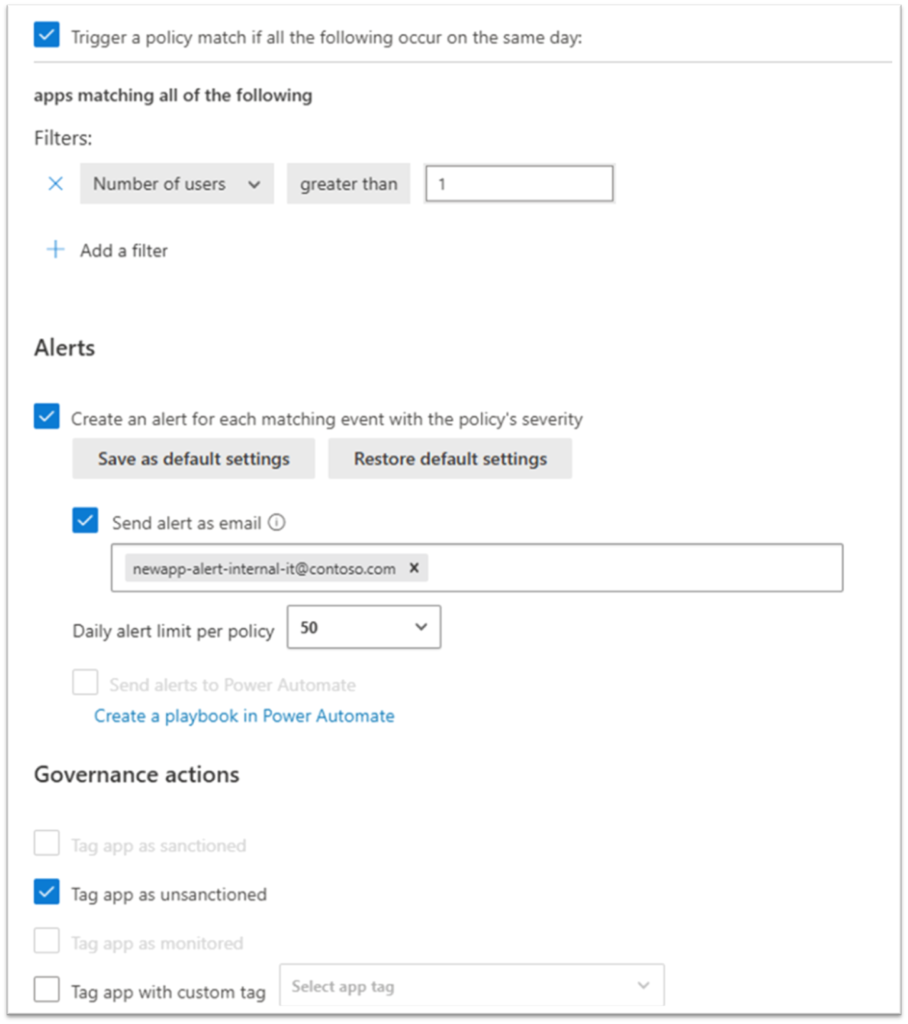

Und jetzt definieren wir in der Policy weiter, was dann passieren soll:

Im Screenshot sind die zwei wesentlichen Dinge zu sehen:

- Es wird ein Alert an eine definierte E-Mail geschickt. (gut wäre, wenn die existiert, diese auch gelesen wird und ein passender Prozess für die weitere Bearbeitung definiert wurde und dieser auch bekannt ist! – Wie komme ich nur immer darauf, dass das nicht der Fall sein könnte… 🤔)

- Die identifizierte App wird automatisch auf „unsanctioned“, also „blockiert“ gestellt und ist ab diesem Moment auf den Geräten, auf denen MDE installiert und konfiguriert ist, nicht mehr zugreifbar.

Das heißt, dass für den Fall, dass plötzlich ein neues AI Tool genutzt wird, die IT Zeit bekommt, eine Bewertung dieser fancy, neuen App vorzunehmen, ohne Angst haben zu müssen, dass hier unwissentlich Daten abfließen.

Á propos Daten abfließen: natürlich existiert immer auch die Gefahr, dass für die Nutzung private/BYOD Geräte genutzt werden. Nur durch eine stringente Umsetzung von Data Loss Prevention Maßnahmen kann dies verhindert oder zumindest deutlich erschwert werden, so dass von einer „ich wusste das gar nicht“ Aktion nicht mehr die Rede sein kann. Auf diese DLP Maßnahmen gehe ich hier allerdings nicht ein.

Fazit

Es besteht dringender Handlungsbedarf aus Datenschutz- und Datensicherheitsgründen. Damit dies auch leistbar ist, benötigt die IT die Unterstützung von Automation.

In diesem Blogpost habe ich ausgeführt, wie dies über eine einzelne Policy möglich ist.

Grundvoraussetzung ist natürlich die Nutzung von Microsoft Defender for Endpoint als EDR Tool und die Verfügbarkeit der notwendigen Lizenzen (z.B. Microsoft 365 E5 Security) für die Nutzung von MDE und MDCA. Allerdings bin ich der Meinung, dass diese eh vorhanden sein sollte, um den modernen Arbeitsplatz ganzheitlich abzusichern!

Siehe dazu auch den englischen Blogpost: Discover, monitor and protect the use of Generative AI apps (microsoft.com)

1 Wie immer gilt: ich schließe explizit niemanden aus und beziehe in jegliches Genus alle anderen mit ein – für die Inklusion und die Lesbarkeit verwende ich immer nur genau ein Genus in beliebiger Reihenfolge! 🔙