Was hat Delve mit File recommendations und noch „schlimmer“ mit AI zu tun?

Agenda

- Hintergrund

- Welche Probleme gibt es bei der Nutzung von Delve?

- Warum aber gibt es diese Bedenken?

- Ja, aber!

- Und nun noch AI? (Fazit)

- Zusatz: File recommendations

Hintergrund

Vor laaanger Zeit (vor 2015, genaues Datum habe ich nicht mehr gefunden) haben wir Office Delve, bzw. Microsoft Delve gelauncht. Delve hat den Zweck, dass Informationen den User1 finden und nicht die Userinnen danach suchen müssen.

Das funktioniert über ein ausgeklügeltes System, welches – immer basierend auf den entsprechenden Userrechten – verfolgt, welche Date(ie)n grade „heiß“ für den Aufrufenden sind.

„Heiß“ bedeutet z.B., dass eine geteilte Datei viel von anderen Berechtigten genutzt wird, oder, dass die Erstellung noch nicht lange zurückliegt.

Delve ist für mich ein sehr gutes Instrument, um auf Daten, die ich sonst umständlich hätte Suchen (und Finden) müssen, schnell zuzugreifen bzw. Dateien, die ich sonst vielleicht nie gesehen hätte, mir aber doch hätten helfen können, nutzen kann.

Update: Delve erreicht(e) im Dezember 2024 sein End of Life: Guidance for retiring Delve in your organization – SharePoint in Microsoft 365 | Microsoft Learn – und der Grund ist überraschend einfach: dafür gibts ja Copilot! 😉🧑✈️

Welche Probleme gibt es bei der Nutzung von Copilot oder Delve?

Jedoch gibt es viele – viel zu viele, wenn ihr mich fragt – Unternehmen, die aus Angst und Bauchgefühl diese Technologie abschalten.

Das wird meist mit „Der Betriebsrat will das so!“ oder „Das verstößt gegen DSGVO!“ begründet – %SPOILER% beide Begründungen sind bei näherer Betrachtung nicht zu halten, da sie nur ein anderes Problem (siehe unten) kaschieren, aber im Sinne einer 0-Risikobetrachtung (was ja sonst immer gerne ins Feld geführt wird) keine Relevanz haben!

Warum aber gibt es diese Bedenken?

Weil mittels Copilot/Delve dem User oft Dinge vor Augen kommen, „die sie gar nicht hätte sehen dürfen“.

Und schon geht es los mit dem Microsoft Bashing: das gibt ja Auskünfte darüber, wie und wann John Doe gearbeitet hat!

(naja, wenn die Anzeige, „Stephanus hat am 6.9.2023 um 14:00h ein Dokument geöffnet“ wirklich eine Aussage über meine Arbeit gibt… vor allem müssen diese Informationen auch immer hinterfragt werden, bzw. würde ich nicht zu 100% meine Hand für die Genauigkeit ins Feuer halten! Letztlich ist das eine ähnliche Diskussion wie die um den Status bei z.B. Microsoft Teams! Daher gehe ich da nicht weiter drauf ein!)

Oder: wie können die sowas nur Lieschen Müller zeigen oder das hätte Max Mustermann niemals sehen sollen!

Ja, aber!

Das mag inhaltlich zwar stimmen, aber das Problem liegt nicht an Copilot/Delve!

Sondern daran, dass der Tenantbetreibende seine Data Governance nicht im Griff hat!

Was meine ich damit? Copilot/Delve nutzt (wie auch andere, siehe weiter unten) die Recommendation API aus dem „ominösen“ Microsoft Graph.

Jetzt ist es so, dass der Microsoft Graph – und auch alle damit verbundenen sonstigen Technologien – die Berechtigungen der aufrufenden Userin berücksichtigen!

Sprich, und das möchte ich sehr laut sagen:

Wenn ein User keine Berechtigung auf eine Datei hat, dann wird der Graph/Copilot/Delve/File recommendations auch NIEMALS eine solche Datei dem User anzeigen!

Ergo, wenn also ein Kunde/Tenantbetreibender/Betriebsrat/Datenschützer ein Problem mit Copilot/Delve haben sollte, dann hat er/sie/es eigentlich ein Problem mit der eigenen Data Governance und Berechtigungsstruktur!

Daher also meine Frage:

Lieber ein Pflaster auf die Wunde legen (aka. Copilot/Delve verbieten) oder doch lieber das Problem an der Wurzel packen (Data Governance einführen und praktizieren)?

Ich denke, die (Rhetorische) Antwort ist klar!

Und nun noch AI? (Fazit)

Um so mehr, als dass sich das Problem noch viel eklatanter zeigen wird, sobald KI Technologie auf die gleichen APIs zugreifen wird. Also sobald z.B. der Microsoft 365 Copilot eingeführt wird, wird sich das identische Verhalten, nur diesmal unter einem Brennglas, zeigen, denn Copilot berücksichtigt die genau identischen Berechtigungen und wenn die also nicht stimmen, dann kann es auch nicht funktionieren!

Ich bezeichne an dieser Stelle Delve auch immer so:

Microsoft Delve ist für mich der Pen-Test ob ein Tenant/Kunde heute schon bereit für AI ist! Und wenn nicht, dann wird es Zeit, dies anzugehen!

Daher mein Aufruf: jeder (!) kümmert sich jetzt um seine Data Governance und nutzt dann gelassen die neue KI Welt zum Wohle aller!

Siehe dazu auch meinen Blogbeitrag: DataHero: Mit Data Governance einfach mal die KI-Welt retten

Deal?

Zusatz: File recommendations

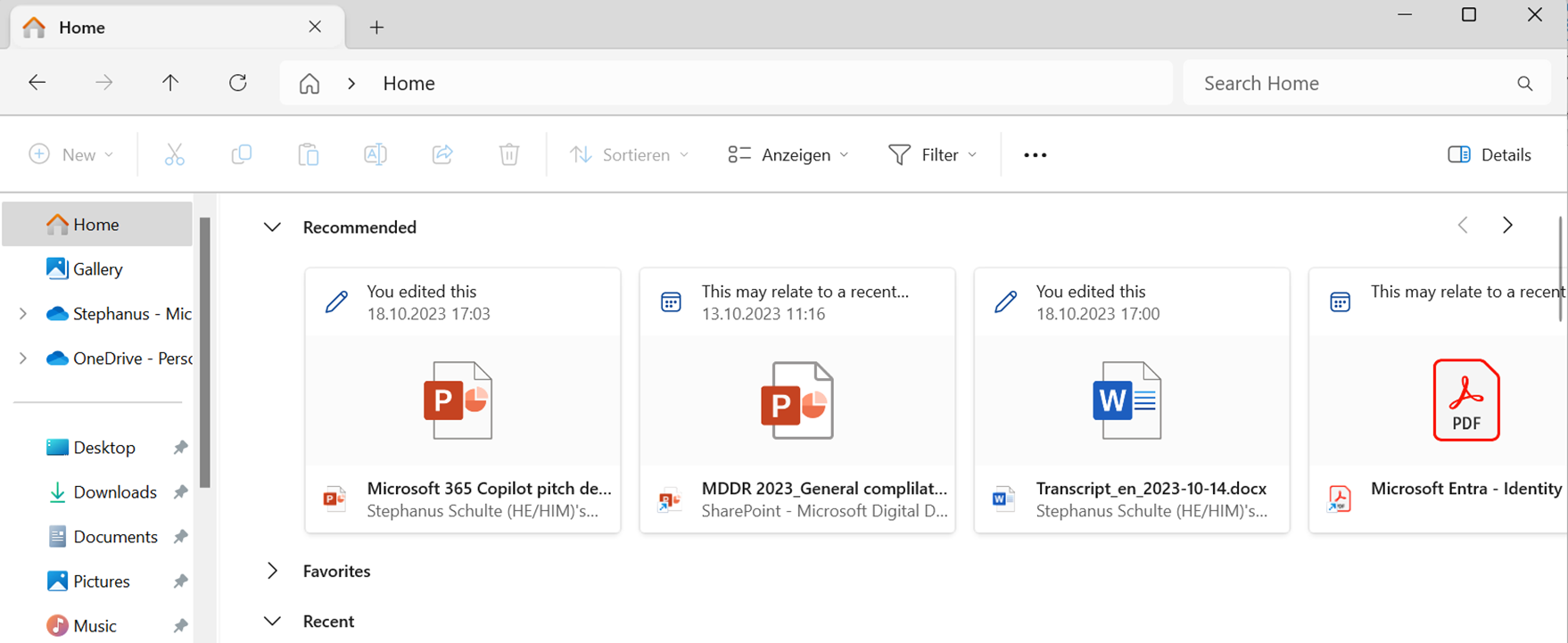

Mit einer Insider (#23403) Version von Windows 11 haben wir in den Windows File Explorer eine neue Rubrik in der „Home“ / „Start“ Ansicht eingeführt: die „Recommendations“:

Diese zeigen mir ähnliche Inhalte wie Microsoft Delve an – klar, sie kommen aus der identischen Graph API!

Finde ich toll, denn ich bin viel öfter im File Explorer als in Delve!

Für die, die es trotzdem den Usern schwerer machen wollen: ja, kann man z.B. per Group Policy deaktivieren: GPS: Turn off account-based insights, recent, favorite, and recommended files in File Explorer (gpsearch.azurewebsites.net)

- für den Lesefluss und die Inklusion von sichteingeschränkten Menschen (Stw. Screenreader) verzichte ich im Fließtext auf Gendern, möchte aber ausdrücklich darauf aufmerksam machen, dass ich ALLE Menschen einschließe! ↩︎

Kommentare

3 Antworten zu „Kopf in den Sand, AI oder doch delven?“

[…] AI und die Datengovernance: Kopf in den Sand, AI oder doch delven? – Stephanus (st-s.info) […]

[…] Kopf in den Sand, AI oder doch delven? habe ich bereits das Dilemma aufgezeigt, dass Rollen- und Rechte-Management nicht neu ist und […]

[…] Denn, in meinen Diskussionen mit Kunden und Microsoft Partnern, kommt regelmäßig – ja eigentlich immer – die Frage auf: wie können wir denn verhindern, dass unsere Userinnen1 KI Tools nutzen, ohne, dass wir diese freigegeben, also geprüft und legitimiert, hätten oder überhaupt davon wissen, dass dies passiert.Siehe dazu auch Kopf in den Sand, AI oder doch delven? […]