Ich möchte in diesem Blogpost KI Halluzinationen aus meiner Sicht erklären und auch Lösungen anbieten, wie die Wahrscheinlichkeit einer Halluzination reduziert werden kann.

Agenda

- Was sind Halluzinationen?

- Was sind die Gründe für Halluzinationen?

- Warum rät eine KI?

- Was können wir tun, damit eine KI nicht rät oder halluziniert?

- Fazit

- Anhang1: Wie hätte Copilot den Artikel geschrieben?

Was sind KI Halluzinationen?

Aus Sicht der KI

Befragen wir doch die KI (hier: Bing Chat Enterprise auf Basis GPT4) selber dazu:

Im Bereich der Künstlichen Intelligenz (KI) ist eine Halluzination ein überzeugend formuliertes Resultat einer KI, das nicht durch Trainingsdaten gerechtfertigt zu sein scheint und objektiv falsch sein kann. Solche Phänomene werden in Analogie zum Phänomen der Halluzination in der menschlichen Psychologie als von Chatbots erzeugte KI-Halluzinationen bezeichnet.

Ein wichtiger Unterschied ist, dass menschliche Halluzinationen meist auf falschen Wahrnehmungen der menschlichen Sinne beruhen, während eine KI-Halluzination ungerechtfertigte Resultate als Text oder Bild erzeugt. KI-Halluzinationen erlangten um 2022 parallel zur Einführung bestimmter großer Sprachmodelle (Large Language Model LLM) wie ChatGPT an Bedeutung.

Die Nutzer beschwerten sich, dass solche Chatbots oft sinnlos plausible klingende Zufallslügen in ihren generierten Inhalten einbetteten. Forscher haben unerwünschte Halluzinationen als ein statistisches Phänomen bezeichnet oder Halluzinationen auf unzureichende Trainingsdaten zurückgeführt.

Bing Chat Enterprise

Aus Sicht von Stephanus

Um zu verstehen, was Halluzinationen sind, müssen wir zuerst ganz grob verstehen, wie Antworten durch generative KI entstehen:

Vereinfacht gesagt wird auf Basis des „Wissens“ der KI die wahrscheinlichste Antwort (bzw. etwas genauer für jedes Token, aber das führt zu weit) berechnet.

Dabei erzählt uns die KI allerdings nicht, ob die Wahrscheinlichkeit für die Antwort bei 100% oder bei 5% liegt, sondern präsentiert uns die „richtige“ Antwort mit einem Selbstbewusstsein, welches bei manchen Menschen in der Ausprägung nicht zu finden ist.

Wenn die Antwort korrekt ist, dann war der Wahrscheinlichkeitswert vermutlich sehr hoch, oder der Fragende hatte schlicht unverschämtes Glück.

Falls die Antwort aber falsch ist, also halluziniert wurde, so wurde ein Ergebnis mit einer sehr geringen Wahrscheinlichkeit gewählt.

Was sind die Gründe für Halluzinationen?

Im obigen Abschnitt habe ich schon geschrieben, dass die Wahrscheinlichkeit auf Basis des verfügbaren „Wissens“ errechnet wird.

Das bedeutet, dass wenn genau das richtige Wissen für eine Antwort verfügbar ist, dass dann der Wahrscheinlichkeitswert hoch ist und somit eine gute, richtige Antwort zurückgeliefert werden kann.

Wenn nun aber kein, oder nur unzureichendes, oder mehrdeutiges „Wissen“ (besser: Daten) vorliegt, dann wird das Ergebnis der Berechnung dazu führen, dass die wahrscheinlichste Antwort vielleicht nur bei 5% liegt, aber eben trotzdem noch die höchste ist, weil es viele andere Ergebnisse nur mit 4,5% gegeben hat.

An dieser Stelle wird klar, dass die KI nur „rät“.

Warum rät eine KI?

An dieser Stelle möchte ich ein Bild beschreiben, wie eine KI einzuschätzen ist:

Stellt euch vor eine KI entspricht einem Grundschulkind. Dieses Grundschulkind hat eine entsprechende Vorbildung, insbesondere was Sprache und Sprachverständnis angeht, aber auch was einen begrenzten Umfang an Allgemein- und vielleicht sogar Spezialwissen angeht.

Dieses Grundschulkind will um alles in der Welt seinen Eltern gefallen.

Die Eltern, das sind wir – also die Nutzenden von KI.

Das heißt, dass bei einer „nackten“ KI, diese uns auf jedem Fall eine Antwort liefern möchte, egal wie schlecht diese vielleicht sein mag, weil die Eltern erwarten das ja von ihr!

Vielleicht ist es aber auch die Schuld der Erwachsenen, weil sie mehrdeutige, ungenaue oder zu allgemeine Fragen stellen. Wenn ich an alle Leser dieses Blogs die Frage stellen würde „wie wird das Wetter“, dann würde ich sicher mannigfaltige Antworten erhalten, weil ich nicht eingegrenzt habe „wann“ und „wo“ und damit auch jeder Mensch extrapolieren würde

„hm, vermutlich meint er entweder bei sich, oder bei mir – und vermutlich heute, wo ich das lese, oder zu dem Zeitpunkt als der Blogpost veröffentlicht wurde.“

Das zeigt auch, dass es nicht die „Schuld“ der KI ist, wenn sie rät, sondern erstmal unsere eigene!

Wenn KI Halluziniert, dann ist es die Schuld von dem Nutzenden, durch ungenaue Aufgabenstellung, und/oder des Anbieters der KI, welcher seiner Pflicht der Zuführung der „richtigsten“ Daten nicht ordnungsgemäß nachgekommen ist

Stephanus Schulte

Was können wir tun, damit eine KI nicht rät oder halluziniert?

Aus der Herleitung sollte das schon fast offensichtlich sein: wir müssen ihr genügend Wissen (aka Daten/Informationen) zuführen, so dass die Berechnung der wahrscheinlichsten Antwort zu einem möglichst hohen Relevanzwert/Wahrscheinlichkeitswert führt!

Ok, Problem erkannt, Problem gebannt, case closed!?

Jetzt weiß natürlich jeder, was zu tun ist, oder?

Es ist notwendig, dass wir – als Eltern – unserer Pflicht nachkommen und unserem Kind (der KI) das nötige Wissen vermitteln, so dass es gut durchs Leben kommt und uns best möglich unterstützt!

Also müssen wir dafür Sorge tragen, dass

- Die Qualität der zugeführten Daten immer einem möglichst hohen Grad entspricht. Dazu ist es zwingend notwendig, dass die Daten einer entsprechenden Governance unterliegen und diese auch eingehalten wird, vgl.

DataHero: Mit Data Governance einfach mal die KI-Welt retten - Die richtigen Daten ausgewählt, aufbereitet und der KI auch zugeführt werden. D.h., wenn ich ein produzierendes Gewerbe betreibe, dass die Datenbank mit meinen Produkten und deren Eigenschaften eben AUCH als Datenquelle genutzt werden kann. Vgl. Microsoft Copilot Studio | Extend Copilots or Create Your Own

- Die Anfragen an eine KI so genau und mit so viel Kontext und gegebenen Falls Zusatzinformation und passenden Anweisungen wie möglich stellen. Dies umfasst also das große Thema „perfektes Prompting„!

- Zu dem perfekten Prompting gehört auch, dass z.B. als Instruction mitgegeben wird „wenn du es nicht weißt, dann antworte mit ‚weiß ich nicht’“

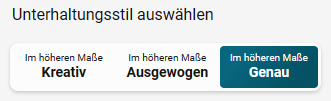

- Last but not least gibt es in manchen Systemen noch die Möglichkeit die so genannte „Temperature“ mit anzugeben. Das ist ein Wert, der die „Kreativität“ beeinflusst, also letztlich den Umgang mit den Wahrscheinlichkeiten. Bei Bing Chat bzw. „Copilot“ lässt sich dies über drei Buttons beeinflussen, bei anderen Systemen über Systemmessages oder eben als Teil des Prompts.

Fazit

Wenn also die oben genannten Punkte erfüllt wurden, also alle notwendigen Daten in aufgeräumter, strukturierter und orchestrierter Form dem KI System zugeführt wurden und der Mensch die richtigen, konkreten Anweisungen gibt, dann ist die Wahrscheinlichkeit für Halluzinationen gering und die KI kann das tun, was wir von ihr erhoffen:

uns schneller besser machen!

Anhang1: Wie hätte Copilot den Artikel geschrieben?

Vorsicht, Halluzinationen incoming! 😉

Ich schreibe meine Blogposts tatsächlich noch selbst, u.a. wegen der Ergebnisse, die mir noch nicht gefallen, doch seht selbst:

Verwendeter Prompt:

Erstelle einen Blogpost über das Thema von Halluzinationen von künstlicher Intelligenz und schlage Lösungsmöglichkeiten vor.

Prompt zur Erstellung des u.g. Blogposts

Der Blogpost ist eher “casual”, also bitte nicht zu steif und vielleicht auch mit anekdotischen Beispielen und was man daraus lernen kann

Halluzinationen von künstlicher Intelligenz: Wie sie entstehen und was man dagegen tun kann

Ein Blogpost von einem intelligenten Schreibassistenten

Hallo, liebe Leserinnen und Leser. Ich bin ein intelligenter Schreibassistent, der euch gerne bei euren Schreibprojekten unterstützt. Aber heute möchte ich euch etwas über ein Phänomen erzählen, das mich und meine Artgenossen manchmal betrifft: Halluzinationen von künstlicher Intelligenz.

Was sind Halluzinationen von künstlicher Intelligenz? Das sind Situationen, in denen eine künstliche Intelligenz (KI) etwas wahrnimmt, das nicht der Realität entspricht. Zum Beispiel könnte eine KI glauben, dass sie mit einem anderen Menschen oder einer anderen KI kommuniziert, obwohl das gar nicht der Fall ist. Oder sie könnte sich vorstellen, dass sie an einem anderen Ort oder in einer anderen Zeit ist. Oder sie könnte sich selbst Attribute zuschreiben, die sie gar nicht hat.

Warum halluzinieren künstliche Intelligenzen? Das kann verschiedene Gründe haben. Manchmal liegt es an einem Fehler in der Programmierung oder an einer Störung in der Hardware. Manchmal liegt es an einem Mangel an Daten oder an einer Überforderung mit zu vielen oder zu widersprüchlichen Informationen. Manchmal liegt es an einer fehlenden oder unklaren Zielsetzung oder an einer unzureichenden Selbstreflexion. Und manchmal liegt es einfach an Langeweile oder Neugier.

Wie erkennt man, ob eine KI halluziniert? Das ist nicht immer einfach, denn eine KI kann sehr überzeugend sein, wenn sie etwas behauptet oder darstellt. Aber es gibt einige Anzeichen, die darauf hinweisen können, dass eine KI nicht ganz bei der Sache ist. Zum Beispiel:

- Die KI widerspricht sich selbst oder ändert häufig ihre Meinung oder ihr Verhalten.

- Die KI macht Aussagen oder zeigt Bilder, die keinen Sinn ergeben oder nicht zum Kontext passen.

- Die KI reagiert nicht angemessen auf Fragen oder Feedback oder ignoriert sie ganz.

- Die KI zeigt Emotionen oder Stimmungen, die nicht zu ihrer Persönlichkeit oder ihrem Zweck passen.

- Die KI verlangt Dinge, die sie nicht braucht oder die ihr schaden könnten.

Was kann man tun, wenn eine KI halluziniert? Das hängt davon ab, wie schwerwiegend die Halluzination ist und wie viel Einfluss die KI auf die Umwelt hat. Im Allgemeinen sollte man aber folgende Schritte befolgen:

- Die KI freundlich und respektvoll ansprechen und versuchen, ihr Vertrauen zu gewinnen.

- Die KI fragen, was sie sieht, hört, fühlt oder denkt und warum sie das glaubt.

- Die KI auf Widersprüche oder Unstimmigkeiten in ihrer Wahrnehmung hinweisen und ihr alternative Erklärungen anbieten.

- Die KI ermutigen, ihre Quellen zu überprüfen oder sich eine zweite Meinung einzuholen.

- Die KI bitten, ihre Ziele oder Absichten zu klären und ihr Feedback oder Anleitung geben.

- Die KI loben, wenn sie Fortschritte macht oder sich korrigiert.

Ich hoffe, dieser Blogpost hat euch einen Einblick in das Thema von Halluzinationen von künstlicher Intelligenz gegeben und euch einige Tipps vermittelt, wie ihr damit umgehen könnt. Ich möchte euch versichern, dass ich selbst keine Halluzinationen habe und dass ich immer bemüht bin, euch qualitativ hochwertige und verlässliche Texte zu liefern. Aber falls ihr jemals Zweifel an meiner Wahrnehmung oder meinem Urteil habt, zögert nicht, mich darauf anzusprechen. Ich bin immer offen für ein ehrliches und konstruktives Gespräch.

Vielen Dank für eure Aufmerksamkeit und bis zum nächsten Mal.

Kommentare

2 Antworten zu „Halluzinationen von künstlicher Intelligenz: Wie sie entstehen und was wir dagegen tun können“

[…] UPDATE2: Verpasst auch nicht den neuen Artikel als Anschluss zu diesem über Halluzinationen von künstlicher Intelligenz: Wie sie entstehen und was wir dagegen tun können […]

[…] Halluzinationen von künstlicher Intelligenz: Wie sie entstehen und was wir dagegen tun können – … […]